Ubuntu Docker安装并使用的方法

Docker Engine-Community 支持以下的 Ubuntu 版本:

- Xenial 16.04 (LTS)

- Bionic 18.04 (LTS)

- Cosmic 18.10

- Disco 19.04

- 其他更新的版本……

Docker Engine - Community 支持上 x86_64(或 amd64)armhf,arm64,s390x (IBM Z),和 ppc64le(IBM的Power)架构。

一、使用官方安装脚本自动安装

安装命令如下:

curl -fsSL https://get.docker.com | bash -s docker --mirror Aliyun

也可以使用国内 daocloud 一键安装命令:

curl -sSL https://get.daocloud.io/docker | sh

手动安装

卸载旧版本

Docker 的旧版本被称为 docker,docker.io 或 docker-engine 。如果已安装,请卸载它们:

$ sudo apt-get remove docker docker-engine docker.io containerd runc

当前称为 Docker Engine-Community 软件包 docker-ce 。

安装 Docker Engine-Community,以下介绍两种方式。

二、使用 Docker 仓库进行安装

在新主机上首次安装 Docker Engine-Community 之前,需要设置 Docker 仓库。之后,您可以从仓库安装和更新 Docker 。

设置仓库

更新 apt 包索引。

$ sudo apt-get update

安装 apt 依赖包,用于通过HTTPS来获取仓库:

$ sudo apt-get install \

apt-transport-https \

ca-certificates \

curl \

gnupg-agent \

software-properties-common

添加 Docker 的官方 GPG 密钥:

$ curl -fsSL https://mirrors.ustc.edu.cn/docker-ce/linux/ubuntu/gpg | sudo apt-key add -

9DC8 5822 9FC7 DD38 854A E2D8 8D81 803C 0EBF CD88 通过搜索指纹的后8个字符,验证您现在是否拥有带有指纹的密钥。

$ sudo apt-key fingerprint 0EBFCD88

pub rsa4096 2017-02-22 [SCEA]

9DC8 5822 9FC7 DD38 854A E2D8 8D81 803C 0EBF CD88

uid [ unknown] Docker Release (CE deb) <docker@docker.com>

sub rsa4096 2017-02-22 [S]

使用以下指令设置稳定版仓库

$ sudo add-apt-repository \ "deb [arch=amd64] https://mirrors.ustc.edu.cn/docker-ce/linux/ubuntu/ \ $(lsb_release -cs) \ stable"

安装 Docker Engine-Community

更新 apt 包索引。

$ sudo apt-get update

安装最新版本的 Docker Engine-Community 和 containerd ,或者转到下一步安装特定版本:

$ sudo apt-get install docker-ce docker-ce-cli containerd.io

要安装特定版本的 Docker Engine-Community,请在仓库中列出可用版本,然后选择一种安装。列出您的仓库中可用的版本:

$ apt-cache madison docker-ce docker-ce | 5:18.09.1~3-0~ubuntu-xenial | https://mirrors.ustc.edu.cn/docker-ce/linux/ubuntu xenial/stable amd64 Packages docker-ce | 5:18.09.0~3-0~ubuntu-xenial | https://mirrors.ustc.edu.cn/docker-ce/linux/ubuntu xenial/stable amd64 Packages docker-ce | 18.06.1~ce~3-0~ubuntu | https://mirrors.ustc.edu.cn/docker-ce/linux/ubuntu xenial/stable amd64 Packages docker-ce | 18.06.0~ce~3-0~ubuntu | https://mirrors.ustc.edu.cn/docker-ce/linux/ubuntu xenial/stable amd64 Packages ...

使用第二列中的版本字符串安装特定版本,例如 5:18.09.1~3-0~ubuntu-xenial。

$ sudo apt-get install docker-ce=<VERSION_STRING> docker-ce-cli=<VERSION_STRING> containerd.io

测试 Docker 是否安装成功,输入以下指令,打印出以下信息则安装成功:

$ sudo docker run hello-world

Unable to find image 'hello-world:latest' locally

latest: Pulling from library/hello-world

1b930d010525: Pull complete Digest: sha256:c3b4ada4687bbaa170745b3e4dd8ac3f194ca95b2d0518b417fb47e5879d9b5f

Status: Downloaded newer image for hello-world:latest

Hello from Docker!

This message shows that your installation appears to be working correctly.

To generate this message, Docker took the following steps:

1. The Docker client contacted the Docker daemon.

2. The Docker daemon pulled the "hello-world" image from the Docker Hub.

(amd64)

3. The Docker daemon created a new container from that image which runs the

executable that produces the output you are currently reading.

4. The Docker daemon streamed that output to the Docker client, which sent it

to your terminal.

To try something more ambitious, you can run an Ubuntu container with:

$ docker run -it ubuntu bash

Share images, automate workflows, and more with a free Docker ID:

https://hub.docker.com/

For more examples and ideas, visit:

https://docs.docker.com/get-started/

三、使用 Shell 脚本进行安装

Docker 在 get.docker.com 和 test.docker.com 上提供了方便脚本,用于将快速安装 Docker Engine-Community 的边缘版本和测试版本。脚本的源代码在 docker-install 仓库中。 不建议在生产环境中使用这些脚本,在使用它们之前,您应该了解潜在的风险:

- 脚本需要运行 root 或具有 sudo 特权。因此,在运行脚本之前,应仔细检查和审核脚本。

- 这些脚本尝试检测 Linux 发行版和版本,并为您配置软件包管理系统。此外,脚本不允许您自定义任何安装参数。从 Docker 的角度或您自己组织的准则和标准的角度来看,这可能导致不支持的配置。

- 这些脚本将安装软件包管理器的所有依赖项和建议,而无需进行确认。这可能会安装大量软件包,具体取决于主机的当前配置。

- 该脚本未提供用于指定要安装哪个版本的 Docker 的选项,而是安装了在 edge 通道中发布的最新版本。

- 如果已使用其他机制将 Docker 安装在主机上,请不要使用便捷脚本。

本示例使用 get.docker.com 上的脚本在 Linux 上安装最新版本的Docker Engine-Community。要安装最新的测试版本,请改用 test.docker.com。在下面的每个命令,取代每次出现 get 用 test。

$ curl -fsSL https://get.docker.com -o get-docker.sh $ sudo sh get-docker.sh

如果要使用 Docker 作为非 root 用户,则应考虑使用类似以下方式将用户添加到 docker 组:

$ sudo usermod -aG docker your-user

卸载 docker

删除安装包:

sudo apt-get purge docker-ce

删除镜像、容器、配置文件等内容:

sudo rm -rf /var/lib/docker

二、创建容器

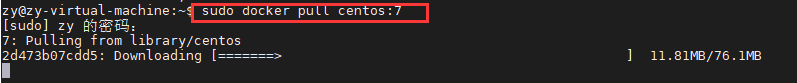

拉取镜像:sudo docker pull centos:7

启动并创建容器:

sudo docker run -itd --privileged --name singleNode -h singleNode \ -p 2222:22 \ -p 3306:3306 \ -p 50070:50070 \ -p 8088:8088 \ -p 8080:8080 \ -p 10000:10000 \ -p 60010:60010 \ -p 9092:9092 \ centos:7 /usr/sbin/init

进入容器:sudo docker exec -it singleNode /bin/bash

此时就成功进入容器

五、Docker中搭建大数据环境

安装组件

yum clean all yum -y install unzip bzip2-devel vim bashname

配置SSH免密登录

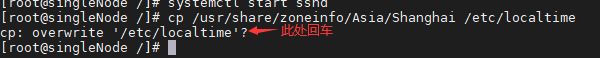

yum install -y openssh openssh-server openssh-clients openssl openssl-devel ssh-keygen -t rsa -f ~/.ssh/id_rsa -P '' cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys # 启动SSH服务 systemctl start sshd

设置时区

cp /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

如果有防火墙需要关闭一下:

systemctl stop firewalld systemctl disable firewalld

创建文件夹:

#存放解压包 mkdir -p /opt/install

退出容器:exit

将大数据组件包上传至Ubuntu中的一个目录下,创建目录名为software

将Ubuntu中的组件包复制一份到容器中

sudo docker cp /home/zy/software/ singleNode:/opt/

重新进入容器

sudo docker exec -it singleNode /bin/bash

安装MySQL

进入到安装包路径下

cd /opt/software

解压包

tar zxvf MySQL-5.5.40-1.linux2.6.x86_64.rpm-bundle.tar -C /opt/install

安装依赖

yum -y install libaio perl

安装服务端和客户端

#先到MySQL解压后的路径 cd /opt/install #安装服务端 rpm -ivh MySQL-server-5.5.40-1.linux2.6.x86_64.rpm #安装客户端 rpm -ivh MySQL-client-5.5.40-1.linux2.6.x86_64.rpm

启动并配置MySQL

#第一步:启动 systemctl start mysql #第二步:配置用户名密码 /usr/bin/mysqladmin -u root password 'root' #第三步:进入mysql mysql -uroot -proot #第四步:配置 > update mysql.user set host='%' where host='localhost'; > delete from mysql.user where host<>'%' or user=''; > flush privileges; #安装完成退出 quit

安装JDK

解压包

tar zxvf /opt/software/jdk-8u171-linux-x64.tar.gz -C /opt/install/

创建软连接

#取别名为:java ln -s /opt/install/jdk1.8.0_171 /opt/install/java

配置环境变量:

vi /etc/profile #添加以下配置信息 export JAVA_HOME=/opt/install/java export PATH=$JAVA_HOME/bin:$PATH

生效配置文件:

source /etc/profile

查看Java版本:

java -version

安装Hadoop

解压包

tar zxvf /opt/software/hadoop-2.6.0-cdh5.14.2.tar_2.gz -C /opt/install/

创建软连接

ln -s /opt/install/hadoop-2.6.0-cdh5.14.2 /opt/install/hadoop

配置core-site.xml

vi core-site.xml

-------------------------------------------

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://singleNode:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/install/hadoop/data/tmp</value>

</property>

</configuration>

-------------------------------------------

配置hdfs-site.xml

vi hdfs-site.xml

-------------------------------------------

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property

</configuration>

-------------------------------------------

配置mapred-site.xml

vi mapred-site.xml.template

-------------------------------------------

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>singleNode:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>singleNode:19888</value>

</property>

</configuration>

-------------------------------------------

配置yarn-site.xml

vi yarn-site.xml ------------------------------------------- <configuration> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.resourcemanager.hostname</name> <value>singleNode</value> </property> <property> <name>yarn.log-aggregation-enable</name> <value>true</value> </property> <property> <name>yarn.log-aggregation.retain-seconds</name> <value>604800</value> </property> </configuration> -------------------------------------------

配置hadoop-env.sh

vi hadoop-env.sh ------------------------------------------- export JAVA_HOME=/opt/install/java -------------------------------------------

配置mapred-env.sh

vi mapred-env.sh ------------------------------------------- export JAVA_HOME=/opt/install/java -------------------------------------------

配置yarn-env.sh

vi yarn-env.sh ------------------------------------------- export JAVA_HOME=/opt/install/java -------------------------------------------

配置slaves

export HADOOP_HOME=/opt/install/hadoop export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

HDFS格式化

hdfs namenode -format

启动Hadoop服务

start-all.sh

web端查看

#地址 192.168.**.**:50070

安装Hive

解压包

tar zxvf /opt/software/hive-1.1.0-cdh5.14.2.tar.gz -C /opt/install/

创建软连接

ln -s /opt/install/hive-1.1.0-cdh5.14.2 /opt/install/hive

修改配置文件:

#到配置文件路径下 cd /opt/install/hive/conf/

修改hive-site.xml

vi hive-site.xml

-------------------------------------------

<configuration>

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/home/hadoop/hive/warehouse</value>

</property>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://singleNode:3306/hive?createDatabaseIfNotExist=true</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>root</value>

</property>

<property>

<name>hive.exec.scratchdir</name>

<value>/home/hadoop/hive/data/hive-${user.name}</value>

<description>Scratch space for Hive jobs</description>

</property>

<property>

<name>hive.exec.local.scratchdir</name>

<value>/home/hadoop/hive/data/${user.name}</value>

<description>Local scratch space for Hive jobs</description>

</property>

</configuration>

-------------------------------------------

修改hive-env.sh.template

vi hive-env.sh.template ------------------------------------------- HADOOP_HOME=/opt/install/hadoop -------------------------------------------

添加依赖

cp /opt/software/mysql-connector-java-5.1.31.jar /opt/install/hive/lib/

添加环境变量

vi /etc/profile #添加以下配置信息 export HIVE_HOME=/opt/install/hive export PATH=$HIVE_HOME/bin:$PATH

启动服务

nohup hive --service metastore & nohup hive --service hiveserver2 &

查看进程:jps

安装Sqoop

解压包

tar zxvf /opt/software/sqoop-1.4.6-cdh5.14.2.tar.gz -C /opt/install/

创建软连接

ln -s /opt/install/sqoop-1.4.6-cdh5.14.2 /opt/install/sqoop

修改sqoop-env-template.sh

cd /opt/install/sqoop/conf/ vi sqoop-env-template.sh ------------------------------------------- #Set path to where bin/hadoop is available export HADOOP_COMMON_HOME=/opt/install/hadoop #Set path to where hadoop-*-core.jar is available export HADOOP_MAPRED_HOME=/opt/install/hadoop #Set the path to where bin/hive is available export HIVE_HOME=/opt/install/hive -------------------------------------------

添加依赖包

cp /opt/software/mysql-connector-java-5.1.31.jar /opt/install/sqoop/lib/ cp /opt/software/java-json.jar /opt/install/sqoop/lib/

添加环境变量

vi /etc/profile #添加以下配置信息 export SQOOP_HOME=/opt/install/sqoop export PATH=$SQOOP_HOME/bin:$PATH

查看版本

sqoop version

到此这篇关于Ubuntu Docker安装并使用的方法的文章就介绍到这了,更多相关Ubuntu Docker安装使用内容请搜索脚本之家以前的文章或继续浏览下面的相关文章希望大家以后多多支持脚本之家!

相关文章

利用 trap 在 docker 容器优雅关闭前执行环境清理的方案

这篇文章主要介绍了利用 trap 在 docker 容器优雅关闭前执行环境清理的问题,需要在容器的启动脚本中,加入 trap 指令,来完成容器在退出前需要做的所有事情,本文通过脚本示例给大家介绍的非常详细,需要的朋友参考下吧2021-12-12

最新评论