Python 爬虫使用动态切换ip防止封杀

上次有说过,我在新公司有部分工作是负责爬虫业务的,爬虫机器有上百台,节点也要计划迁入了Docker平台上。 这两天遇到一个棘手的问题,就是因为我们为了追求数据量,在某些机房,用docker启动了不少爬虫节点,导致一些傻逼网站,开始封禁我们…. … (干死他们,哥们要是有资源,必须干掉ddos,让你防 ! 当然我也就装装逼,没这个资源)

对于爬虫被封禁 ! 爬虫一般来说只要你的ip够多,是不容易被封的。 一些中小网站要封杀你,他的技术成本也是很高的,因为大多数网站没有vps,他们用的是虚拟空间或者是sae,bae这样的paas云。 其实就算他们不考虑seo搜索优化,用ajax渲染网页数据,我也可以用webkit浏览器组件来搞定ajax之后的数据。

如果某个网站他就是闲的蛋疼,他就是喜欢从log里面,一行行的分析出你的ip,然后统计处频率高的网站, 那这个时候咋办? 其实方法很草比,就是用大量的主机,但是大量的主机是有了,你如果没有那么爬虫的种子量,那属于浪费资源… … 其实一个主机,多个ip是可以的。。。

这个时候是有两种方法可以解决的,第一个是用squid绑定多个ip地址,做正向代理…. 你的程序里面维持一组连接池,就是针对这几个正向proxy做的连接池。

正向代理和反向代理最大的区别就是,反向代理很多时候域名是固定的,而正向代理是通过一个http的代理端口,随意访问,只是在proxy端会修改http协议,去帮你访问

如果是python,其实单纯调用socket bind绑定某个ip就可以了,但是标题的轮训是个什么概念,就是维持不同的socket bind的对象,然后你就轮吧 ! 跟一些业界做专门做爬虫的人聊过,他们用的基本都是这样的技术。

# -*- coding=utf-8 -*-

import socket

import urllib2

import re

true_socket = socket.socket

ipbind='xx.xx.xxx.xx'

def bound_socket(*a, **k):

sock = true_socket(*a, **k)

sock.bind((ipbind, 0))

return sock

socket.socket = bound_socket

response = urllib2.urlopen('http://www.ip.cn')

html = response.read()

ip=re.search(r'code.(.*?)..code',html)

print ip.group(1)

在http://stackoverflow.com/ 上也找到一些个老外给与的解决方法的思路,他是借助于urllib2的HTTPHandler来构造的出口的ip地址。

import functools

import httplib

import urllib2

class BoundHTTPHandler(urllib2.HTTPHandler):

def __init__(self, source_address=None, debuglevel=0):

urllib2.HTTPHandler.__init__(self, debuglevel)

self.http_class = functools.partial(httplib.HTTPConnection,

source_address=source_address)

def http_open(self, req):

return self.do_open(self.http_class, req)

handler = BoundHTTPHandler(source_address=("192.168.1.10", 0))

opener = urllib2.build_opener(handler)

urllib2.install_opener(opener)

import functools

import httplib

import urllib2

class BoundHTTPHandler(urllib2.HTTPHandler):

def __init__(self, source_address=None, debuglevel=0):

urllib2.HTTPHandler.__init__(self, debuglevel)

self.http_class = functools.partial(httplib.HTTPConnection,

source_address=source_address)

def http_open(self, req):

return self.do_open(self.http_class, req)

handler = BoundHTTPHandler(source_address=("192.168.1.10", 0))

opener = urllib2.build_opener(handler)

urllib2.install_opener(opener)

那么就有一个现成的模块 netifaces ,其实netifaces模块,就是刚才上面socket绑定ip的功能封装罢了

地址: https://github.com/raphdg/netifaces

import netifaces

netifaces.interfaces()

netifaces.ifaddresses('lo0')

netifaces.AF_LINK

addrs = netifaces.ifaddresses('lo0')

addrs[netifaces.AF_INET]

[{'peer': '127.0.0.1', 'netmask': '255.0.0.0', 'addr': '127.0.0.1'}]

import netifaces

netifaces.interfaces()

netifaces.ifaddresses('lo0')

netifaces.AF_LINK

addrs = netifaces.ifaddresses('lo0')

addrs[netifaces.AF_INET]

[{'peer': '127.0.0.1', 'netmask': '255.0.0.0', 'addr': '127.0.0.1'}]

感谢阅读,希望能帮助到大家,谢谢大家对本站的支持!

相关文章

- Notepad++怎么配置python?Notepad++中只能写代码,却不能运行代码,但是如果配置了python就可以直接运行代码了,很方便,下面我们就来看看Notepad++配置python的教程,需2016-09-22

Python在Linux、windows、Mac os等操作系统下都有相应的版本,不管在什么操作系统下,它都能够正常工作。除非使用平台相关功能,或特定平台的程序库,否则可以跨平台使用。2016-09-22

Python在Linux、windows、Mac os等操作系统下都有相应的版本,不管在什么操作系统下,它都能够正常工作。除非使用平台相关功能,或特定平台的程序库,否则可以跨平台使用。2016-09-22

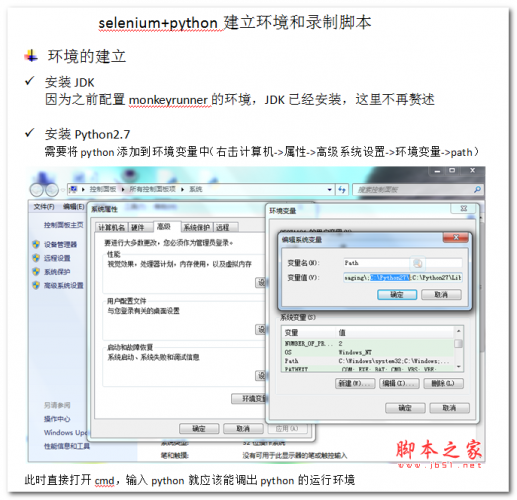

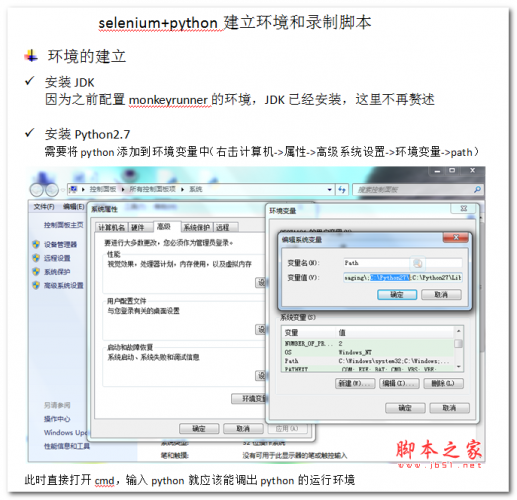

selenium+python建立环境和录制脚本 中文WORD版

本文档主要讲述的是selenium+python建立环境和录制脚本;感兴趣的朋友可以过来看看2016-09-22

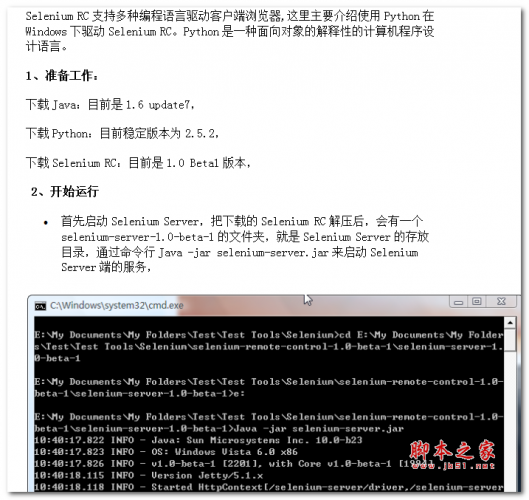

Python+selenium自动化测试入门 (孔祥祝) 中文PPT版

Selenium是一款基于web应用程序的开源测试工具。Selenium测试直接运行在浏览器中,就像真正的用户在操作一样。它支持Firefox、ie、Mozilla等众多浏览器。它同时直至JAVA、C2016-09-22

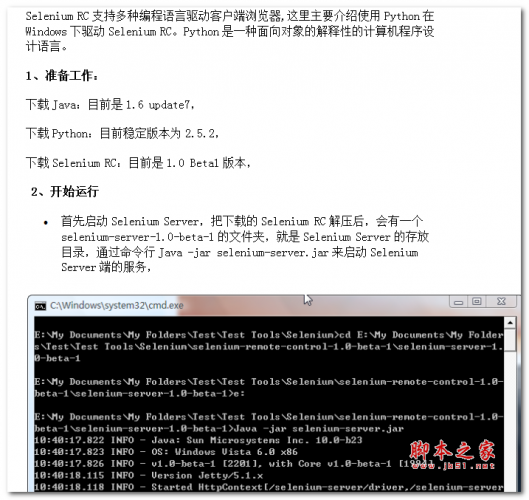

使用Python进行Selenium自动化测试 中文WORD版

Selenium RC支持多种编程语言驱动客户端浏览器,这里主要介绍使用Python在Windows下驱动Selenium RC。Python是一种面向对象的解释性的计算机程序设计语言。感兴趣的朋友可以2016-09-22

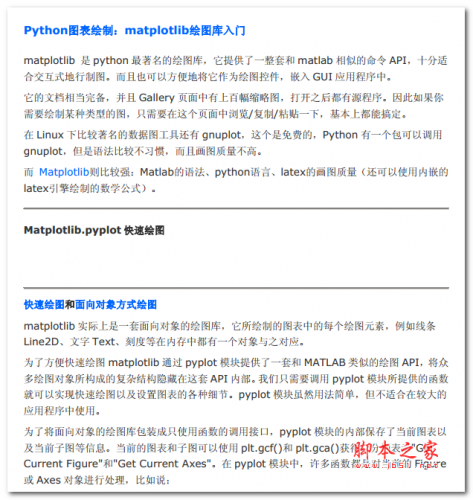

Python图表绘制:matplotlib绘图库入门 中文PDF版

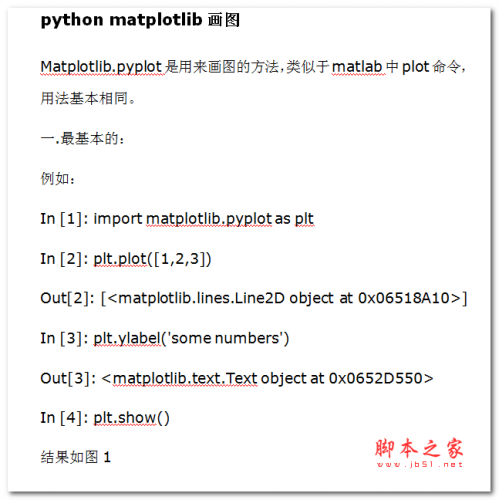

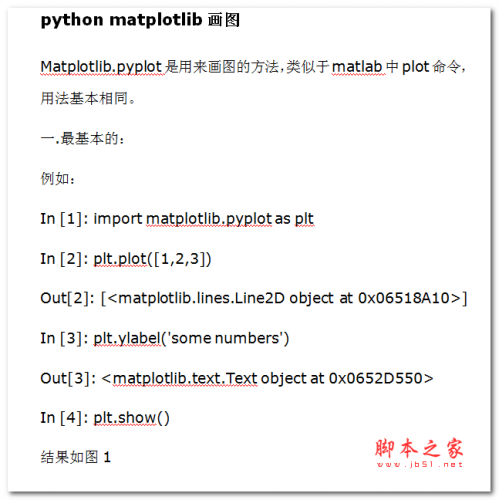

matplotlib是python最著名的绘图库,它提供了一整套和matlab相似的命令API,十分适合交互式地行制图。而且也可以方便地将它作为绘图控件,嵌入GUI应用程序中2016-09-13 Matplotlib.pyplot是用来画图的方法,类似于matlab中plot命令,用法基本相同。本文档主要讲述的是python matplotlib画图;感兴趣的朋友可以过来看看2016-09-13

Matplotlib.pyplot是用来画图的方法,类似于matlab中plot命令,用法基本相同。本文档主要讲述的是python matplotlib画图;感兴趣的朋友可以过来看看2016-09-13

使用Python分析社交网络数据 中文PDF版 2.88MB

Python是一种广泛使用的高级编程语言, 具有可读性强、 编写容易、 类库丰富等特。 作为一种“胶水语言”,它可以将使用其他语言编写的各种模块(尤其是C/C++) 轻松地联结2016-09-13

python网络爬虫(抓取网页的含义和URL基本构成) 中文PDF版 4.25MB

爬虫最主要的处理对象就是URL,他根据URL地址取得所需要的文件内容,然后对它进行一步的处理。因此,准确的理解URL对理解网络爬虫至关重要。感兴趣的朋友可以过来看看2016-09-13

Python数据分析基础教程:NumPy学习指南(第2版) 中文pdf版[5MB]

本书是NumPy的入门教程,主要介绍NumPy以及相关的Python科学计算库,涵盖NumPy安装、数组对象、常用函数、矩阵运算、线性代数、金融函数、窗函数、质量控制、Matplotlib绘2016-07-21

最新评论