一文搞懂英伟达H100/H200 B100/B200 B200/GB200 HGX/DGX的区别和参数

前言,最近英伟达GPU热点一直很高,尤其是对H200,B200的讨论,当然也包括GB200,DGX及HGX等,我简单汇总了以下几个问题,我们今天展开聊聊!

- 1、你清楚H200比H100升级了什么吗?B200与B100的区别呢?

- 2、B200和GB200名字看着很像,有何区别与联系呢?

- 3、我们常见到HGX和DGX,他们是什么产品以及两者间的区别和联系?

- 4、HGX H200\B200,DGX H100\B200的官方参数情况

一、英伟达H200和H100的变化

作为H100的升级款产品,H200消息大家的关注度挺高,其实从整体参数方面H200只升级了GPU显存相关内容,GPU单卡从80G HBM3升级到了141G HBM3e(显存容量和类型有变化),同时显存带宽从3.35TB/s提升至4.8TB/s,整体参数对比如下:

二、英伟达B200和B100的区别

B200和B100都是基于英伟达最新一代Blackwell架构的数据中心GPU,英伟达目前的市场策略是以B200为主,从整体参数上,两者除了显存的规格一致,其他的不同精度的算力、功率有所不同,具体可以见下图,供参考,可以看到B100的TDP是700W,有传言说是为了兼容现有H100的服务器平台(机头)做的设计,但是从综合性能上B200更优,比如FP16算力是H100的2倍以上,同时TDP也提升到了单卡1000W,所以B200的服务器平台需重新设计,与H100的不兼容了。

Blackwell 架构的 GPU

基本技术参数

三、B200和GB200,HGX和DGX的区别

1、认识B200和GB200

从名字上看GB200和B200很容易弄混,尤其是新手朋友,便于大家理解我专门找了2张图,最左侧老黄手持就是B200,是标准的英伟达基于Blackwell架构的GPU芯片,而GB200是芯片的“组合”,如中间图所示,是通过一个板子将2颗B200加上一颗Grace CPU(72核心的ARM架构处理器)组合而成,我们一般GPU服务器上是没法用的,定位是专用的“产品”,是英伟达为了搭建NVL72这类GPU“方案级产品”做的设计,如右图所示它是NVL72的算力节点,包括2个GB200。

2、认识HGX和DGX

很多做英伟达GPU生意的朋友肯定都知道HGX,就是我们所说的“模组”,一套HGX 100模组价格高达200w+,如下图所示,HGX产品的核心是8块GPU,通过底板进行整合,同时也集成了NVLink技术和NVLink SW的芯片。这个“大家伙”是英伟达设计的,是H100 SXM GPU直接提供给服务器的厂商的“最小形态”,当然它是无法独立工作的,因为他就是一个“逻辑的大GPU”必须要和服务器平台(机头)组合才能形成一台 完整的GPU服务器。

DGX是英伟达品牌的GPU服务器,如下图所示,除了包括最核的HGX模组外,配套了服务器该有的机箱、主板、电源、CPU、内存、硬盘、网卡等部件。它和我们平时看到的各大服务器厂商推出的基于HGX模组的GPU服务器并无本质区别,英伟达推出DGX 整机和其他服务器厂商形成了竞争关系(又是供应商,又是对手,比较尴尬),一是DGX价格偏高,二是为了避免和服务器厂商的市场冲突,除特定客户外,一般很少见到有主动采购DGX产品的。

四、HGX H100和H200的参数情况

以下图片截自英伟达的官方彩页。

1、HGX H100、HGX H200的参数及对比情况

2、英伟达DGX H100的参数情况

3、英伟达DGX B200的参数情况

补充知识:

芯片

1. GPU芯片

晶体管数:

- B200 GPU的晶体管数量是现有H100的两倍多,但B200封装了2080亿个晶体管(而H100/H200上为800亿个)。这意味着B200芯片封装密度比H100进一步提高,对管理散热和功耗也提出了更高的要求。

FP4精度:

- 引入一种新的计算精度,位宽比FP8进一步降低,B200峰值算力达18P。

FP6精度:

- 位宽介于FP4和FP8之间。

NV高带宽接口(Nvidia High Bandwidth Interface):

B200有两个Die,高速连接通道NV-HBI达到10TB/s。两个Die是一个统一的Cuda GPU。NV-HBI会占用一定的芯片面积。

内存:

- B200每个Die有4个24GB的HBM3e stack,合计一个Cuda GPU有192GB内存,内存带宽达8TB/s。相比H200时代六个内存控制器,可以减少内存接口的芯片面积,从而使得计算面积可以更大。

GB200:

- 有两个B200(4个GPU Die)和一个Grace CPU,2700W。

2. NVLink芯片

第五代NV-Link芯片,双向带宽达1.8TB/s = 18(links) * 50GB/s (bandwidth each direction) * 2,是Hopper GPU使用的第四代NV-Link的2倍。最大支持576个GPU的连接,相比上一代是256个。

3. NVSwitch芯片

第四代NVSwitch芯片,7.2TB/s的全双工带宽,是上一代的两倍。

4. DPU和CPU没有更新

服务器

HGX B200:

- 一机 八B200整机解决方案。每个B200是1000W。

HGX B100:

- 一机 八B100整机解决方案。每个B100是700W。

GB200 SuperPOD 服务器

GB200 superchip:

- 2个CPU和4个B200。这个compute tray是1U的,液冷。

GB200 NVL72:

- 包含18个1U compute tray(共72个B200)、9个Switch Tray(共18个Switch )。

GB200 superPOD:

- 576个B200 GPU。与H100相比,superpod的训练性能提升4倍,推理性能提高30倍,能效提高25倍。

相关文章

计算机技术中的CPU、GPU、APU都是哪类芯片的简称,各有什么用途?下面我们就来看看它们是如何分工协作的,最后我们会给出最佳的选配建议2024-07-29

计算机技术中的CPU、GPU、APU都是哪类芯片的简称,各有什么用途?下面我们就来看看它们是如何分工协作的,最后我们会给出最佳的选配建议2024-07-29 gpu就是显卡的核心 ,也可以直接认为是图形处理器。它是显卡的“大脑”,它决定了该显卡的档次和大部分性能,同时也是2D显示卡和3D显示卡的区别依据,那么玩游戏gpu和cpu吃2022-08-22

gpu就是显卡的核心 ,也可以直接认为是图形处理器。它是显卡的“大脑”,它决定了该显卡的档次和大部分性能,同时也是2D显示卡和3D显示卡的区别依据,那么玩游戏gpu和cpu吃2022-08-22

苹果M1 GPU真实性能出炉 超越GTX 1050 Ti和RX 560

苹果M1 GPU真实性能如何?根据最新的GFXBench 5.0跑分数据库,苹果M1芯片的图形性能超越了NV GeForce GTX 1050 Ti和AMD Radeon RX 560等桌面级独立显卡,详细请看下文介绍2020-11-17 联发科芯片采用arm Cortex A73和A53大小核架构,相较于上一代产品Helio P23与Helio P30,CPU及GPU性能均提升70%2018-02-27

联发科芯片采用arm Cortex A73和A53大小核架构,相较于上一代产品Helio P23与Helio P30,CPU及GPU性能均提升70%2018-02-27

主板和显卡的供电模块由什么元件组成? CPU/GPU供电原理

主板和显卡的供电模块由什么元件组成?我们知道主板和显卡是给给CPU和GPU供电的,在它们是怎么工作的呢?下面我们就来详细的内容,需要的朋友可以参考下2017-02-10

Intel Kaby Lake特别版曝光:CPU和GPU分离设计

今天,爆料人Hard|OCP编辑Kyle Bennett指出,首款处理器产品将在今年推出。具体来,CPU部分基于Kaby Lake,GPU部分基于AMD Radeon,这颗处理器集成度较低,CPU和GPU分离设2017-02-05

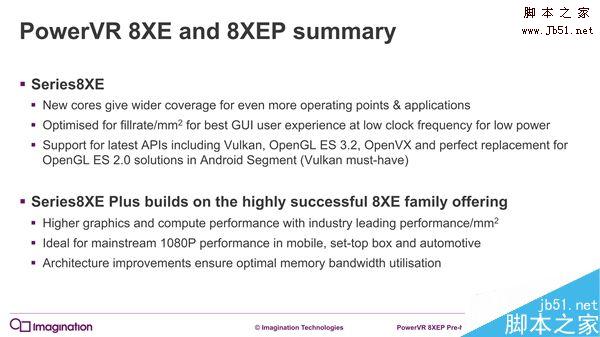

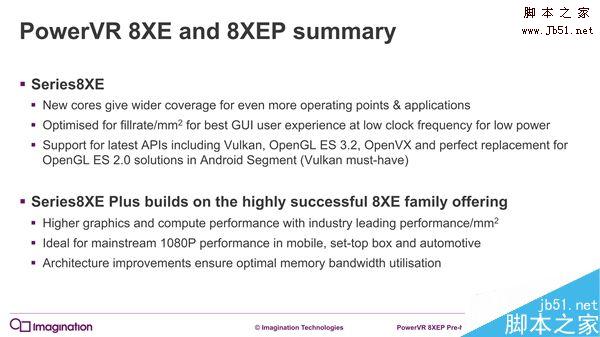

PowerVR series8XE Plus GPU发布:面向中端主流机型

今年是增强版的PowerVR series8XE Plus,主要面向1080p屏幕的中端主流机型,今天登场的PowerVR 8XE Plus基本架构不变,USC(统一着色簇)还是老样子,但重点强化了着色计算能2017-01-19 现在,外媒送上了Vega GPU真片的实拍,因为这一代针脚带宽翻倍、堆叠容量增至8倍,所以HBM2显存的面积明显增大,而Vega采用的是和Fiji一样将GPU核心和显存封装在一块基板上2017-01-06

现在,外媒送上了Vega GPU真片的实拍,因为这一代针脚带宽翻倍、堆叠容量增至8倍,所以HBM2显存的面积明显增大,而Vega采用的是和Fiji一样将GPU核心和显存封装在一块基板上2017-01-06 华为Mate 9搭载华为最新的旗舰芯片麒麟960,基于台积电16nm工艺,CPU是八核心设计,4*A73@2.36GHz 4*A53@1.84GHz,麒麟960的CPU在当下依然处于顶级水准,是安卓阵营的最强2016-11-24

华为Mate 9搭载华为最新的旗舰芯片麒麟960,基于台积电16nm工艺,CPU是八核心设计,4*A73@2.36GHz 4*A53@1.84GHz,麒麟960的CPU在当下依然处于顶级水准,是安卓阵营的最强2016-11-24华为Mate9搭载的麒麟960处理器究竟有多强?华为麒麟960的GPU性能评测

华为昨天晚上在德国慕尼黑正式发布了旗下的新旗舰手机:华为Mate 9和Mate 9“保时捷设计”版。而Mate也首次搭载了华为海思最新研制的麒麟960处理器。那么华为Mate9搭载的麒2016-11-22

最新评论